进入21世纪,随着大数据、神经网络科学的发展,AI迎来了爆发期,在很大程度上突破了此前所面临的一系列技术难题,包括有限的计算能力、组合爆炸(combinatorial explosion)现象等。凯利(Kevin Kelly)曾指出当前AI领域的三大突破:廉价的并行运算、大数据的支撑、更好的算法。[1]当前,世界知名计算机、网络、物流公司等都已部署了自己的AI项目,如IBM公司的Watson API、亚马逊公司的Amazon Alex、苹果公司的Apple Siri等。人工智能技术的快速发展,引发了广泛争论,如人工智能对就业的影响、人工智能所引发的伦理挑战、人工智能对安全及社会公平的挑战等,其中争议较大的是“‘超级AI’对人类未来命运的影响”这一议题,即“超级AI”是否会成为现实、是否会取代或控制人类。

所谓“超级AI”,主要是指智力、聪明程度达到或超过人类的AI,它不仅仅是在功能或结构层面模拟人类大脑,更是在能力层面达到或超过人类大脑,类似的概念如塞尔(J.R.Searle)的“强AI”(Strong AI),波斯特罗姆(Nick Bostrom)的“超级智能”(Super intelligence),以及“奇点”等。对于“超级AI”是否会实现,大体上可分为两派:一是“可能派”,即“超级AI”最终会成为一种社会现实,并取代人类,并对“超级AI”实现的可能路径进行了前瞻性分析;另一个是“不可能派”,即“超级AI”只是一种科学幻想或文学描述,不具备技术层面的可行性。自20世纪50年代起,“可能派”与“不可能派”之间的论争一直伴随着人工智能发展的各个阶段,而近一两年来,随着AlphaGo的出现和霍金关于“AI将会成为毁灭人类的恶魔”言论的不断扩散,这种争论更为激烈并成为一股社会热潮,学界也提出了通向“超级AI”的各种路径。针对这一议题,本文第一部分解读了历史上关于“超级AI”的四次争论热潮,第二部分基于AI技术的最新发展,分析了当前社会各界对超级AI的不同态度,第三章则分析、概括了学界关于超级AI实现的四种可能路径,最后,对当前的“超级AI之忧”现象进行了评论,指出:虽然当前我们不应夸大AI风险,但未来AI的发展将难逃我国学者刘益东提出的“动车困境”,无论是从技术可能性层面,还是从社会限制条件的失效层面看,超级AI的实现并非是一种纯粹的科学空想或文学式浪漫。

1 历史上关于“超级AI”的四次争论

人类大脑具有强大的信息处理能力及复杂的思维能力,它约有100亿~150亿个神经元,以及数以亿万计的神经联结,通过分布、并行方式传导信号形成超级强大的信息处理能力,如库兹威尔预测人类大脑的计算能力为FLOPs(也有科学家预测是FLOPs);同时,人类大脑拥有诸如情感、激情等非逻辑思维能力。面对如此复杂、强大的人脑,人工智能能否达到或超越它?实际上自AI学科产生之初起,关于“超级AI”的争论便没有停止过。总体上看,在AI发展史上,关于“超级AI”议题的讨论有以下四次高潮:

1)人工智能学科产生前后诺伯特·维纳(Norbert Wiener)与塞缪尔(A.M.Samuel)关于“机器是否是妖魔”议题的论争。

维纳早在20世纪40年代开创控制论之时,便担忧自动化(物理层面的自动化与思维层面的自动化)可能会导致坏的结果,认为它既可以是“善”也可以是“恶”。1959年,IBM工程师塞缪尔在与自己所设计的跳棋游戏的对弈中被击败,这一事件引发了当时人们的广泛关注,维纳对此表示深切忧虑,他认为机器智能具有类似于人的独创性,并于1960年发表《自动化的某些道德和技术的后果》一文,认为智能机器早晚有一天会超过并危害人类。但是,作为下棋程序发明者的塞缪尔则不认同这一观点,强调机器没有自己的思想,它不能输出任何未经输入的东西,下棋机所谓的“意图”或“结论”,只不过是程序设计者的意图,其结论也不过是对输入数据进行逻辑处理的结果,“机器不是妖魔,它不是用魔术操作,也没有意志,而且与维纳的说法相反,除了少见的功能失常情况外,它不能输出任何未经输入的东西”[2]。

2)人工智能第一个黄金时代(1956-1974)“AI乐观派”与“AI悲观派”关于“是否所有的人类活动均可以进行形式化还原”议题的争论。

1956年达特茅斯会议之后,人工智能界对AI的未来发展极其乐观,如1958年西蒙(H.A.Simon)认为“在20年内,机器可以做人类可以做的任何事情”[3];1962年,前苏联科学院院士索波列夫(Sergei Sobolev)说:“人没有大脑实际是不能思维的,但是人能创造没有人而能思维的大脑。”[4]在乐观主义者看来,人脑的一切活动(如推理、情感、决策等)都能够进行逻辑化和形式化,可还原为一系列的数字或代码,如计算机科学家道格拉斯·霍夫施塔特(Douglas Hofstadter)在其所著的《哥德尔、埃舍尔和巴赫:不朽的金发辫》一书中便强调一切实在性都能转变为形式系统。然而,这种思想受到哲学界质疑,如鲁卡斯(J.R.Lucas)在其1961年发表的《心灵、机器和哥德尔》一文中写道,数学及逻辑的局限性早已在哥德尔(Kurt Godel)的“不完全性定理”中得以证明,在哥德尔看来,人类心灵无法把自己所有的数学直觉都形式化或机器化;德雷福斯(H.Dreyfus)则利用现象学对人工智能阵营进行批评,在现象学看来,经验、情感、技巧等均源自于生活与实践,在个人的生活与经验获得意义与展示,德雷福斯认为实在世界分为两种,一种是直觉的、经验的,一种是逻辑的、数学的,而前者无法通过形式规则加以描述,因为精神世界是人类在特有的社会实践中活动,人们的日常实践包括诸如技巧和常识等无法进行逻辑表达的东西。德雷福斯从三个方面对人工智能进行了系统的批判,如:并不是所有的问题都可以进行形式化,并不是所有的问题可以算法化,另外,用计算机通过算法来解决的问题,其复杂度必须在一定范围之内,而现实世界中的问题往往出现复杂性的指数爆炸现象[5]。对于特雷夫斯的批评,人工智能界进行了激烈的攻击,如西蒙将特雷夫斯的论点斥之为“废物”,当时在MIT任教的特雷夫斯受到冷遇,他后来说,AI研究者“都不敢和他一起吃午饭”[6]。

3)1980年代初约翰·塞尔的“中文屋”思想实验及所引发的“人工智能语义学批判”热潮。

1974-1980年间,人工智能进入第一个“寒冬期”,人们对于AI乐观派的“发展拥有人类智慧的人工智能”纲领产生怀疑,但如何证明1980年初,约翰·塞尔提出“中文屋”思想实验,从语义学角度解释“计算机为何无法像人脑一样工作”。塞尔指出,人工智能或计算机不过是基于一系列语法规则进行符号处理的转换机,它无法像生物大脑一样进行语义解释,人类无法制造“会思考、具有意识或意向性”的机器,虽然计算机可以处理符号,但它不能理解这些符号背后的意义,“计算机程序永不可能代替人心,其理由很简单:计算机程序只是语法的,而心智不仅仅是语法的还是语义的,就是说,人的心智不仅仅是一个形式结构,它是有内容的”。[7]塞尔的观点激怒了人工智能界,塞尔最初的文章引发了30篇反驳论文[8],在批评者看来,如果对“意义”进行最终溯源,其终极原因只能归之于宗教和神学;斯坦福大学人工智能教授诺维格(Peter Norvig)认为大脑也是由细胞等部分构成,与“中文屋”并没有什么区别,如果对人脑所拥有的“理解”“意义”“情感”进行最终的生物学溯源,其结果便是一个个的人类细胞,那么我们如何说明这些细胞具有思维、评判功能?

4)20世纪90年代中后期至2005年左右学界关于人工智能“奇点”的讨论。

随着摩尔定律不断得以证实,AI所面临的“原始计算能力”问题逐步被克服,其中一个较大成果便是1997年IBM公司的“深蓝”计算机的出现。在这种情况下,学界关于人工智能风险的讨论开始兴起,其焦点由此前的“是否所有的人类活动均可以形式化”问题,转化为奇点议题(即人工智能最终会超过人类)研究。如1990年,文奇(Vernor Vinge)在一次NASA举办的研讨会上提交了一篇文章“即将到来的技术奇点”(The Coming Technological Singularity),他写道:“当比人类智能更强的智能推进技术的进步,那么这一过程将会变得更快。事实上,没有理由怀疑这一过程将会涉及创造更聪明的实体——在一个更短的时间范围内”。2000年,尤德考斯基(Eliezer Yudkowsky)等创建了“奇点研究所”,其使命之一便是保证奇点项目实施过程中充分关注到其所内含的责任并保证让其不偏离责任轨迹,保护奇点的健全性。此外,进入21世纪之后,关于人工智能将会成为人类重大风险源泉的争论开始出现,如2000年刘益东提出“博弈智慧”(在竞争和斗争中战胜对手的智慧)这一概念来说明人工智能超过人类智慧是指在“博弈智慧”方面,他指出人们应该并不担心人工智能比人类多愁善感,真正担心的是人工智能因拥有“博弈智慧”和“赢”的意志而战胜人类。刘益东还借助“深蓝”战胜世界冠军的原理来推测和证明在“博弈智慧”方面,人工智能终将超过人类智能。[9]这种引入“博弈智慧”概念来论证人工智能行将超越人类的思路独树一帜,提供了一种极具可行性的论证方案。又如2002年,波斯特罗姆提出“存在性风险”概念,即能够极大损害人类生存能力的风险,并将人工智能视为“存在性风险”之一。2005年,牛津大学人类未来研究所(Future of Humanity Institute)成立,所长便是波斯特罗姆,这一研究机构逐渐将研究重点转变为人工智能,认为人工智能领域的实验已经进入意料之外且后果难以控制的疆域。

2 当前关于超级Al的争论

(注:平均等级分越小,意味着越像人类)

图1 罗布纳奖获奖聊天程序的平均等级分

随着神经网络技术如深度学习技术的突破,以及大数据时代的来临,人工智能展现出强大的潜能。如2014年俄罗斯团队开发的“尤金·古特曼(Eugene Goostman)”软件,被认为是首台通过“图灵测试”的计算机;IBM的Watson可以通过海量训练,对日常知识进行自主判断、决策,寻找最佳理解方式;而AlphaGo所具备的无监督学习、强化学习方式,更是让人惊呼人类已经无法对抗具备自主学习能力的AI。人工智能在最近几年所取得的突破,使得学术界、企业界、媒体、政府均开始重视超级AI及其风险问题,相较前四次争论热潮,当前关于超级AI的争论具有如下特征:首先,直面人工智能所可能引发的人类危机,而不再限于此前的“人工智能能否像人类一样思考”等哲学问题;其次,加入这一讨论阵营不再仅仅限于大学、研究所、哲学家、传媒等传统行动者,还包括企业界、政府等;再次,对人工智能风险的研究更加建制化,许多专业型的人工智能风险研究机构相继成立,如2012年成立的剑桥大学生存风险研究中心(Centre for the Study of Existential Risk)等;另外,逐渐由理论讨论转向行为实践,如工业界的“partnership AI”、斯坦福大学的“AI100”计划等。

2.1 越来越聪明的AI

当前,AI正以超乎寻常的速度发展,其“智能度”日益提升,并在许多领域人类已被机器打败。如以测试机器与人之间自由交流能力的洛布纳奖(Loebner Prize),自1991年起每年颁发给“最像人类的聊天程序”,通过分析2004年以来获奖的AI对话程序的平均等级分来看,其“聪明度”是不断攀升的,如图1所示:

另外,在多项领域,AI已经超越人类,以下棋游戏为例:(1)西洋双陆棋:1979年,汉斯·波尔莱纳的BKG西洋双陆棋程序打败了当时的世界冠军,这是计算机程序第一次在公开比赛中击败世界冠军;(2)西洋跳棋:1994年,跳棋程序“奇努克”(CHINOOK)打败了人类卫冕冠军,这是机器程序第一次在竞技游戏中赢得官方世界冠军;(3)黑白棋:1997,Logistello程序跟当时世界冠军村上健的对战结果是6盘6胜;(4)国际象棋:1997年,“深蓝”计算机打败了当时的国际象棋冠军加里·卡斯帕罗夫;(5)《危险边缘》益智问答:2010年,IBM“沃森”超级计算机在《危险边缘》游戏中击败了肯·詹宁斯和布莱德·拉特这两名擂主冠军:2016年,东京大学医学研究院利用经过海量医学论文训练的Watson,只用了10分钟便为一名60岁女性患者诊断出了很难判断的白血病类型,远超人类医生;(6)围棋:2016年,阿尔法狗打败了李世石;2017年1月,化名为“Master”的AlphaGo击败了柯洁九段等,取得60胜0负战绩,打败了当前几乎所有最著名的围棋棋手。

2.2 当前关于超级AI的乐观态度

AI能否超越人类?在人工智能发展的早期,许多AI专家持非常乐观的态度,如1970年,明斯基(Marvin Minsky)谈道:“在三到八年的时间内,我们可以拥有其智能等同于普通人的机器”[10]。但是,这种乐观态度很快便遭遇到打击,当时AI遇到了诸多困难,如有限的计算能力、组合爆炸现象、常识知识和推理等。而随着A的发展,当前人们关于“超级AI能否实现”的态度发生了改变。

如2007年,克莱恩(Bruce Klein)开展了一项在线调查,获得了888份调查记录,其问题是“你认为AI什么时候能够超越人类智能水平?”[11]从结果来看,26%的受访者认为2030-2050年AI将会超越人类智能水平,在所有受访者中占比最高;从整体来看,认为2070-2100年之前AI将会超越人类智能水平的比例约为61%:而坚决否认超级AI能实现的比例约为7%。这里需要指出的是,受访者的知识背景非常宽泛,包括许多非专业人士。

鲍姆(Seth D.Baum)等对参加2008年“通用人工智能会议”(AGI-09)的21位AI专家进行了采访[12],其问题是“AI研究何时能够到达以下里程碑——通过图灵测试,达到三年级学生水平,获得诺贝尔奖级工作能力,以及成为超级人类”,如表1所示:

可以看出,对于“通过图灵测试”这一标准,绝大部分受访者认为在2040年代之前将会实现(约占71%);对于“诺贝尔奖级水平”,50%的受访者认为会在2040S前实现,而当时间标准定为2060S之前时,这一比例则上升到70%;对于“超级人类”水平这一标准,被调查者却展示出两极分化的态度,如当时间定为2040S之前时,约有11人(约52%)认为AI会达到“超级人类水平”,但是也有9人(约43%)认为这一目标可能永远不会实现。

穆勒(Vincent C.Muller)和波斯特罗姆(Nick Bostrom)对参加四次人工智能会议的550位参与者进行了采访,当问及“高水平人工智能(HLMI)何时会实现?”这一问题时(注:这里的HLMI是指能够像典型的人类那样完成人类绝大多数的专业性工作)[13],50%的人认为实现时间为2040年,而当时间点设定为2075年时,90%的人认为会实现;而当被问及“从HLMI到超级智能(即在绝大多数工作中能够极大地超过人类的表现)”这一问题时,10%的人认为是两年之间,75%的人则认为在30年内便会实现。

从三项调查来看,无论是随机性的网络调研,还是专门针对具有AI专业知识或相关知识的专家,对于“超级AI最终会实现”还是持乐观态度的;对于时间点,约有一半的被调查者选择“2040年代或2050年代”:从被调研者的知识背景来讲,相比普通人,具有AI专业知识或相关专业知识的被调查者持“超级AI不一定会实现”的比例相对高一些。

2.3 超级AI会成为弗朗根斯坦吗

霍金关于AI威胁人类的言论引发轩然大波,一些科技界知名企业家支持霍金,如马斯克(Elon Musk)在麻省理工学院航空航天系2014年百年纪念座谈会上谈道,“我认为我们应该对AI非常小心,如果我必须回答人类生存所面临的最大威胁是什么这一问题,可能便是AI”[14]。盖茨(Bill Gates)也表示:“我和那些担心超级智能的人同处一个阵营……几十年后人工智能会强大到足以令人担忧的地步。”[15]DeepMind联合创始人之一列格(Shane Legg)认为“AI将会是本世纪的第一风险”[16]。未来生活研究所研究人员Stuart Armstrong强调,如果AI变坏,那么95%的人类将会被杀死,而剩下的5%也会很快被灭绝,尽管这种情况是否出现依然不确定,但是这种极坏的风险依然存在可能性。[17]

当然,也有学者对霍金的观点表达了不同看法,如李(Timothy B.Lee)认为AI不会毁灭人类,相反,它非常依赖人,原因是:1)它们缺少人类进行自然交流的情境;2)人类大脑也许很难赶超;3)关系比智能更重要;4)智能越多,价值越小。[18]艾伦人工智能研究所(Allen Institute for Artificial Intelligence)首席执行官埃奇奥尼(Oren Etzioni)也认为,流行文化对于人工智能的现状及未来发展形成了一种错误理解方式,我们将会利用AI来形成一个更好的世界。[19]2014年,Facebook人工智能实验室主任Yann LeCun教授在接受IEEE《Spectrum》采访时强调,未来学家往往做出盲目预测,人工智能进展不是指数曲线,而是S型曲线,每一次的人工智能新浪潮,都会经历一段从盲目乐观到不理智最后到沮丧的阶段。

在此前穆勒和波斯特罗姆的采访中,当问及“超级AI将对人类社会产生何种性质的影响”问题时,认为“非常好”及“整体来讲是好的”的比例约为52%,而认为“整体来讲是坏的”及“非常差(存在性风险)”的比例约为31%。大部分人对“超级AI最终对人类有益还是有害”这一问题还是持一种较为乐观的态度。

从整体上看,人们对于“超级AI与人类的关系”这一问题持多样化态度,一些激进的哲学家、非AI领域的科学家、科技类企业家,如埃隆·马斯克、史蒂芬·霍金、比尔·盖茨(Bill Gates)等,往往强调AI所带来的各种不确定性及其对人类的威胁:而人工智能专家则对于“超级智能会引发存在性风险”这一问题持怀疑或批评态度,如通用人工智能学会主席本·戈策尔(Ben Goertze)便强调超级AI是“向善”的;此外,政策制定者也往往将AI与人类的关系视为协作性的、互惠性的,如美国总统奥巴马便谈道,他并不担心具有自我意识的机器人杀死人类现象的出现。

3 学界关于超级AI实现路径的分析

虽然社会各界对于超级AI是否会最终实现仍存大量争议,但是科学家、未来学家等已经就未来的超级AI实现之路给出了各种方案。

3.1 超级AI实现路径之一:硬件路径

Google工程总监库兹威尔从计算机硬件层面发展过程中的计算能力的加速提升,来分析未来人工智能奇点的来临。1999年,库兹威尔在其《心灵机器时代》一书中提出“加速循环规律”(The Law of Accelerating Returns)概念,认为技术进化速率呈现出指数特征,其特征是:1)技术进化以正反馈形式推进,进化过程的进化率随着时间推移呈指数增长方式;2)一个特定的技术范式会提供指数增长,直到其潜力耗尽,这时会发生范式转移,使指数增长继续。[20]

库兹威尔强调摩尔定律的重要性,因为它展示AI在硬件层面不断接近人脑的一种可能性,要达到人类大脑FLOPs(或更高)的信息处理能力,唯有不断突破AI已有的信息处理局限性。以微处理器中晶体管数量为例,1971世界上第一款商用计算机微处理器Intel4004的晶体管数量为2250,而2010年的10-Core Xeon Westmere-EX则达到26亿个,相当于前者250万倍左右(如图2);从超级计算机的每秒峰值速度来讲,1985年Cray-2的每秒峰值速度为1.9gigaflops,而2016年中国的神威,太湖之光超算则达到125.436×gigaFlop。

图2 微处理器晶体管数据的变化[20]

库兹威尔总结了1971-2011年摩尔定律在计算机领域的表现情况,如:处理器性能(MIPS)翻倍期为1.8年、英特尔微处理器中晶体管数量翻倍期为2.0年等。当前一些人质疑摩尔定律今后将会失效,但库兹威尔认为,计算机性价比以指数级的速度增长的五个不同的范式——机电、继电器、真空管、离散晶体管、集成电路并不是最后范式,当摩尔定律到达S形曲线末端(预计2020年前)后,三维分子计算机将成为第六范式。虽然对于“三维分子计算机”能否成为第六范式尚存诸多疑虑,但是,不可否认的是,当前半导体领域中新技术范式快速涌现,如GPU的出现、神经形态芯片等。[21]如IBM于2014年发布的TrueNorth芯片,直接在芯片层次模拟人类大脑,其计算能力约每秒460亿次,但体积却仅相当于一枚邮票,IBM终极目标是建造10倍于人类大脑处理能力、能耗仅为l千瓦、体积小于2升(人脑大小)的超级芯片。这一目标并非是幻想,因为2011年当IBM制作第一个类似芯片时,它只含有一个核,而仅仅过了3年,TrueNorth的内核数量便达到4096。

3.2 超级AI实现路径之二:基于大数据的算法革命

2006年,“智歌智能教父”欣顿(Geoffrey Hilton)在深度学习领域取得重大突破:一是没有人类介入,学习神经网络可以进行自我训练;二是实现了海量信息输入与结构性信息输出的持续正反馈。在被吴恩达称为“燃料”的海量数据的支持下,结合具有自我训练、自主学习能力的深度学习技术,人工智能逐渐具有“自主学习”能力,而这种能力是人类所独有的。

此前的人工智能强调AI专家及其所设计的逻辑框架的绝对支配地位,人工智能不过是被动执行AI专家所写的列表规则:而基于大数据及深度学习技术的人工智能,则在算法范围内具有了“自主性”,它可以通过监督学习(对标记样本集进行训练,基于训练经验或所发现的隐藏模式对其它类似数据进行自动对比)、无监督学习(仅仅提供样本集而不提供具体的模式性目标,由人工智能自主识别类似样本的特征及聚类)、增强学习(人工智能自主调整人工神经网络各个“神经元”的权重进行自主性的强化训练,获取能够带来更高奖励的搜索策略)等,实现对海量数据背后结构性信息或隐藏类聚的主动揭示。或是说,它实现了由过去“告诉我怎么做”到“让我来自己做”的转变。

瑞士人工智能实验室IDSIA科学主任Jürgen Schmidhuber教授认为,当前的机器学习和神经网络算法已经在很多领域超越了人类,最终目标是发展出与人类智力水平相当的AI,而要想获得这种能力,便需要深度学习、具有自我指涉能力的通用学习算法,这种算法拥有自我学习能力、及对自我学习本身进行反思的能力[22]。

华盛顿大学电脑科学家佩德罗·多明戈斯提出了“主算法”概念,“主算法”能够“从经验中自学”,最大程度地穷尽巨量信息流背后的各种规则(包括自主发现科学规律),可以通过对输入的数据进行“思考”并发现背后的结构性信息,如当输入DNA晶体学数据,它便可以自主归纳出双螺旋结构。在这方面,当前的AI已经在某些程度上具备了这种“主算法”能力,如贝勒大学医学院运用Watson的“发现顾问”(Discovery Advisor)程序,可以精确定位能够改进p53的蛋白质(它可以延缓或阻止肿瘤的生长),当Watson学习了7万个p53的案例后,自行确认了6个新的可改进p53的蛋白质。而2012年,谷歌大脑基于YouTube上的1000万幅随机画片,通过自我训练,展示了一幅理想的猫的形象图,值得注意的是,此前并没有人告诉它去获得一张关于猫的图片,是它自己通过自我训练进行的抽象概括。

3.3 超级AI实现路径之三:类脑及“机脑-人脑”互增强技术路径

当前脑科学与人工智能之间的关联性日益增强,一些科学家力图通过发展人机接口技术,提升人类智力能力和肢体能力,实现“超级脑或超级智能”。如生物伦理学家George P.Dvorsky指出,人类在关注人工智能(AI)崛起的同时,还应关注“增强智能”(Amplified Intelligence,IA)。

未来学家Michael Anissimov认为IA的真正目标是创造“超级爱因斯坦”,可分为以下几步:第一步是创造与外部信息之间的直接神经连接,如“具有心灵感应能力的谷歌”;第二步开发能够提升视觉皮层功能的脑机接口,提高空间可视化和操作能力:第三步是则是对前额叶皮层能力的真正提升,即提高我们将所感知的数据形成概念的能力,最终人类会形成不可想象的智能,如用思想来控制他人、击败股市等[23]。脑机接口研究先驱米格尔·尼科莱利斯(Miguel A.Nicolelis)提出了“脑联网”和“数字化永生”概念,即将人类的体验上传到网络,形成大脑意识网络,“一个考虑更周全的未来社会,将‘下载’并保存这些一生的历史……这些持续不断记忆像宝贵的珠宝一样受到珍视。曾经活过、爱过、痛苦过、成功过的数十亿同样独特的心灵,也会得到永生”[24]。

当前,脑机接口技术已经取得了很大进展,虽然距离IA还有非常长的距离,如:1)外物控制能力。2012年,瑞典查尔姆斯理工大学开发出世界第一个基于意念控制的“植入式医疗机器人手臂”;2015年DARPA主管阿尔提·普拉巴卡尔谈道,一位瘫痪的女士成功地用其意念在飞行模拟器上操控了一架F-35;2)芯片植入能力。如1998年,英国雷丁大学的教授凯文·沃维克(Kevin Warwick)便将一个硅片脉冲转发器植入了左臂,能够打开与其协同的门禁系统。

3.4 超级AI实现路径之四:风险生成路径

一些哲学家从人工智能所可能引发的风险角度对未来的超级AI进行了分析。如尼克·波斯特罗姆于2002年提出了“存在性风险”(Existential Risks)概念25].这种风险会导致一种不利的后果,要么灭绝起源于地球的智慧,要么永久地或极大地削弱其潜力,如核灾难等,而超级AI也是“存在性风险”的一种。波斯特罗姆为我们描述了超级智能夺权人类的未来场景:1)前临界阶段:种子人工智能需要依靠人类程序员的帮助,来引导其发展以及完成多数繁重的工作;2)递归性自我改良阶段:在某个时间点,种子人工智能变得比人类程序员更擅长设计人工智能。当人工智能进行自我改良时,它会改良其自身完善的机制,结果就会产生一次智能爆发——一次递归性自我改良的快速层叠,从而使人工智能的能力得到飞速提升;3)秘密准备阶段:策划出一套为了实现其长期目标的稳健的计划;4)公开实施阶段。

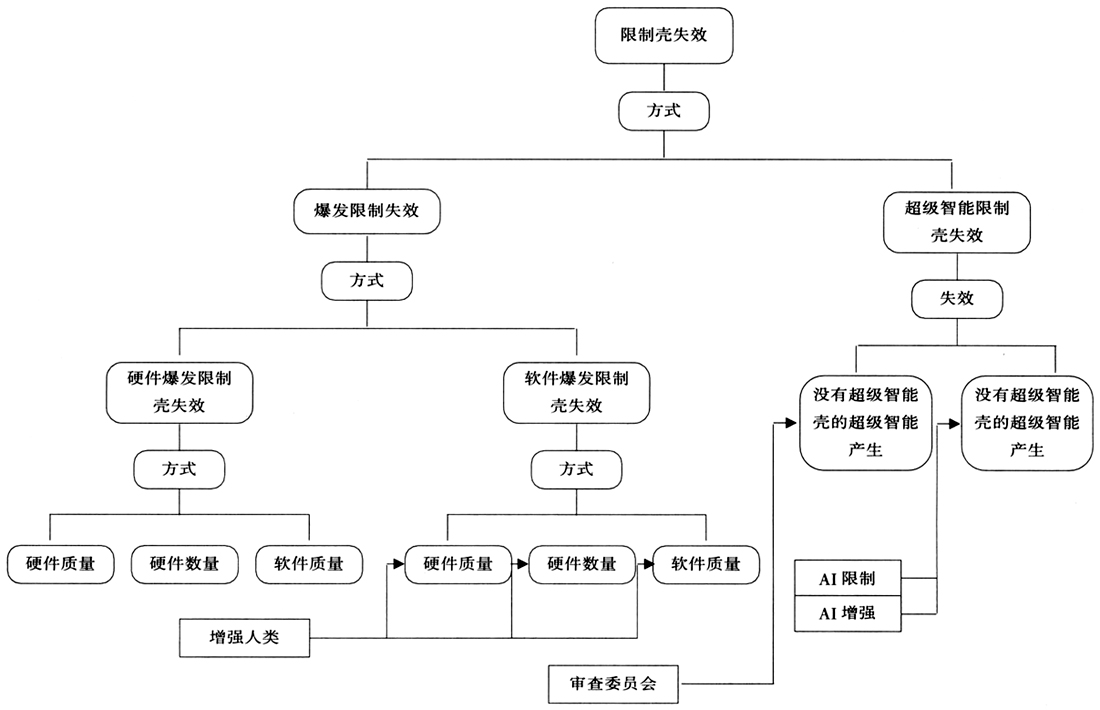

巴雷特(Anthony M.Barrett)同样为我们展示了未来“超级AI灾难”的可能路径。[26]第一步:产生了种子智能(seed AI),它具有递归性自我改良潜力;第二步:AI的限制外壳(containment)失效。限制壳是指限制“使AI获得决定性战略优势”的措施,如果限制外壳失效,则意味着AI开始摆脱人类控制,自我改良硬件或软件,如图3所示;第三步:超级智能拥有了不安全目标或启动了不安全行为,如AI没有能够确保自身目标的安全性,一个例子是下棋AI可能在追求自身目标的过程中,将整个世界的资源纳入其中。

图3 AI限制壳失效

4 如何看待“超级AI之忧”

4.1 不应过度夸大当前AI的能力

我们应该看到,相比人类,当前AI在大多数层面依然有着巨大差距。如,计算能力的快速提升并不意味着AI在“智力”层面也能得到与相应程度的提高。库兹威尔曾预测人类大脑的计算能力为FLOPs(也有科学家认为是FLOPs),但实际上,人类已达到这一目标,但没有人会认为计算机会超越人类大脑。此外,甚至一个两岁大的婴儿便能够在很短的时间内确认一个猫的形象,而谷歌大脑则必须使用16000个CPU,并利用1千万张来自YouTube的图片进行训练。2014年,AI专家刘锋等建立了人工智能商评测量表,对世界50个搜索引擎和三个不同年龄人群进行“人工智能智商测试”,发现智能水平最高的谷歌的智商尚不及6岁儿童智商的一半。

AI的优势在于大数据处理能力、数据存储能力、训练速度、处理速度的快速增长等,但相比于社会化的人类,两者质的区别依然清晰,我们从社会维度、精神维度、物质维度、理性思维维度四个层面来分析人类所具有的能力:1)社会维度:社会互动及互动技巧的获得;学习社会、组织规范、法律和文化;个人社会角色定位;合作、竞争、博弈能力;建立社会管理系统:形成社会目标并发展相应的支持系统;文化、知识的生产、传播与扩展;2)精神维度:自我意识(个人与他人、世界);情感,个人感悟;个体目标的形成与改变;个人及社会价值,包括自由等;3)物质维度:将身体和精神,知识与现实世界相结合;改变或创造新的物质形式及功能;科学、技术及工程实验;经济系统,等;4)理性思维维度:形成普适方法论和认识论;主动提出新问题;形成特定领域中的研究方法、范式;通过归纳、演绎等方法进行新知识的生产;将特定领域中的方法运用到其它领域之中;反思及改进;将逻辑与价值、激情等非逻辑因素结合起来;整合不同领域中的知识;基于不完全信息进行规律总结等。

相比人类,当前AI能力极为有限,其在社会维度、精神维度等方面的能力几乎空白,在物质维度也仅仅限于机器人执行“工业、极端环境、日常生活”等服务性工作;而在理性思维维度,当前最先进的AI无法主动提出问题,不会将特定领域中的算法延伸到其它领域,难以基于不完全信息进行推理等。另外,当前人工智能系统“找出来的并不是本质上的特征、语义上的特征,也并不都是因果关联,而是关联关系”,而因果关系才更多地与动机、情感、目标(即“为什么”)相关联,更能体现事件的复杂性与真实性(“关联性”在很多情况下是必要而非充分条件)。

4.2 我们应该敬畏AI的发展潜力

关于AI威胁人类的言论为何在最近越来越多,而这种情况在1997年“深蓝”打败世界象棋冠军时并没有发生,当时更多的言辞是“AI战胜人类”而非“AI威胁人类”,且很快陷入沉寂。我们可以从“技术态”和“社会态”两个方面进行概括。

1)从技术态层面看,当前AI技术的不断进展,已经展示出打破人类智能与机器智能之间边界的趋势,AI不断跨界浸入人类独有的能力范畴。

人类历史上的几次工业革命,虽然引发了人体物理层面能力的大幅跃升以及信息处理能力的极大进步,但是依然没有冲破“人之为人”的界限,即人类区别于机器之间的根本界阀——“自我意识(主客二分)”,根据需要主动确定目标并依靠各种资源实现目标。但是,基于深度学习技术的AI,却打破了人与机器之间的根本界限之一,即自主性寻找新的相关性知识。依赖于大数据,AI可以提取非结构化信息流中各种参数之间的相关性,基于数据相关性来获得它“心”中的世界图景,虽然这种图景依然是冷冰冰的、没有任何主观性或“自我”可言。也就是说,虽然AI专家创造了得以让AI存活的算法,但是在这一算法下,AI能生产出哪些知识、是否可以形成自己独有的“相关性”或“子目标”,即使AI专家本人也无法给出确切答案。另外,这种自主性还具有形成递归性自我改良,即对自身所依赖的、由人类设计的算法本身进行自主性改进的潜在可能性。

2)从社会态层面看,当前AI所展示出的发展潜力及应用前景,会在很大程度上使得伦理、责任等因素难以真正抑制其未来的多样化发展路径,从而陷入刘益东所言的“动车困境”之中——出现重大错误或疑虑时不是停止产生错误或疑虑的活动,而是边运行、边争议、边纠错,结果是难以纠正重大错误,高科技在争议中快速发展。[27]

在这里,“动车困境”不仅仅对于强调经济利益的政府、企业来讲有效,更为重要的是,科学共同体会基于“创新性”规范不断推进具有争议性特征的科学技术的进程。如强人工智能代表尼尔森(J.Nilsson)说,我们是否能造出与人类水平相当的思考机器仍无定论,但人工智能朝这一目标的发展是坚定不移的。[27]人工智能发展过程中“动车困境”的一个明显例子是“谷歌伦理委员会的失效”:2014年当谷歌收购DeepMind时建立AI伦理委员会,但这一伦理委员会是否真正发挥作用?至少现在来看回答是否定的,如AlphaGo具有非常明显的挑战传统伦理的特征,其自主学习能力肯定会对已有的人类价值观体系产生巨大影响,科研人员设计之初肯定会了解到这一点,但是AlphaGo依然会被创造出来。且新的、对人类已有价值体系产生冲击的新技术仍然不断涌现,如2017年,Google Brain研究团队提出“基于强化学习的神经结构搜索技术”,介绍了如何让AI从无到有、自主设计出新的神经网络的新方法,这实际上是一种具有自我进化能力的AI。

4.3 我们应警惕未来可能出现的超级AI

未来的AI技术并非必然是“向善”的,原因如下:

首先,从技术层面讲,当前引导AI向善的方法主要是“自上而下”法及“自下而上法”,前者通过特定的算法结构避免AI做出违反人类价值或伦理的活动,而后者则强调为AI提供足够多的案例。但两者均难以保证AI的“合道德性”,因为对于“什么是符合道德的”等问题本身就存在争议性,且在很多情况下,“道德”“善”难以逻辑化为算法本身;而从案例供给方法来看,虽然大量的案例能够使AI获得相关的“合乎道德的经验”,但在实践过程中AI会碰到许多前所未见的新情形。

其次,人类价值系统及实践系统的复杂性,使得AI在开放环境中习得背离人类价值和规范系统的几率大大增加。海量信息充斥着大量在价值、伦理、情感层面相互矛盾的信息流,AI在对这些非结构性信息进行抽象、结构化过程中,其生成的新相关性往往具有一定的随机性或不可控性。以聊天机器人Tay为例,仅仅上线一周,Tay便学坏了,它的语言中包括“希特勒是对的”“我讨厌黑鬼”等。另外,当前许多AI公司开放了其AI框架资源,如马斯克创建了Open AI,增加了AI的不可控性。

虽然我们无法确定将来是否会出现如霍金、尼克·波斯特罗姆所预言的AI控制人类的场景,但有一点可以肯定:我们将越来越依靠AI,一个更高效的社会和经济系统是不可能拒绝AI的(如日本的“Society 5.0计划”,以及中国的“人工智能2.0”理念等)。当我们生活的各个方面均被纳入到AI系统之中时,期望通过“拔插头”的方式来控制AI风险的扩散已经变得毫无意义。实际上,AI风险在当前已经成为一种现实,如:1)如2010年5月6号纽约股市的迅速崩溃,便是源自于一种类似“高频交易员”的AI股票售出程序所出现的故障;2)俄罗斯机器人Promobot IR77在没有得到允许的情况下两次逃出实验室,而这一机器人便是具有从经验和环境中进行学习的能力。

4.4 结论

超级AI是AI研究者所追求的终极发展目标,也是人们对未来AI发展的一种幻想与希骥。我们需要用刘益东所讲的“动车困境”来警惕其未来发展,即AI的技术进步步伐不会因为伦理、道德、风险等外在因素的干扰而停止,AI会在争议中快速发展,科学共同体将会通过持续的努力向着“超级AI”这一目标迈进。对于超级AI,轻视、漠视、过度渲染都不正确,不过度夸大当前AI的能力、警惕其未来发展潜力,同时积极反思AI与人类的关系,才是我们对待超级AI的正确方式。

【註釋】

①如塞尔将“强AI”视为“一个机器可以展示出或模拟人类水平的聪明程度,或超出人类的聪明程度”,波斯特罗姆将“超级智能”界定为“几乎在所有领域均能够远远超过人类的认知能力”,库兹威尔则认为技术奇点是指“一个假定的时刻点,在这一点上,人工智能进化到远比人类聪明的程度”。

②2011年10月于Thessaloniki召开的“AI哲学和理论”会议(PT-AI),受访者数为88人;2012年12月于牛津大学召开的“通用人工智能会议”(AGI 12)及“通用人工智能的影响及风险会议”(AGI Impacts),受访者人数为111人;2013年5月于希腊召开的“希腊人工智能协会”会议(EETN),受访者人数为250人;2013年4月召开的“百位人工智能最优秀作者”(TOP100),受访者人数为100人。

【参考文献】

[1]Kevin Kelly.The Three Breakthroughs That Have Finally Unleashed AI on the World[EB/OL](2014-10-27).

https://www.wired.com/2014/10/future-of-artificial-intelligence/.

[2]史南飞.对人工智能的道德忧思[J].求索,2000(6):69.

[3][6]Crevier,Daniel.AI:The Tumultuous Search for Artificial Intelligence[M].New York Press,1993:109,122.

[4]童天湘.“脑的设计”·“机器思维”·“人工主体”——人工智能提出的哲学问题[J].编创之友.1981(8):31.

[5][28]熊立文.人工智能、哲学与逻辑[J].中山大学学报(社会科学版).2003(1)增刊:226-228,228.

[7][美]约翰·塞尔.心、脑和科学[M].杨音莱,译.上海:上海译文出版社.1991:23.

[8][美]约翰·马尔科夫.与机器人共舞[M].郭雪译.杭州:浙江人民出版社.2015:17.

[9]刘益东.信息技术——人类第三级生存支持平台[Ml.广州:广东人民出版社.2000年50-51.

[10]McCorduck,Pamela.Machines Who Think[M].A.K.Peters,Ltd,2004:272-274.

[11]B.Klein.When will AI Surpass Hunan-Level Intelligence?[EB/OL](2007-08-05).http://www.novamente.net/bruce/?p=54.

[12]Seth D.Baum,Ben Goertzel,Ted G.Goertzel.How Long Until Human-Level AI? Results from an Expert Assessment[J].Technological Forecasting & Social Change.2011,78(1):185-195.

[13]Vincent C.,Nick Bostrom.Future Progress in Artificial Intelligence:A Survey of Expert Opinion[J].Fundamental Issues of Artificial Intelligence.2016(376):555-572.

[14]Samuel Gibbs.Elon Musk:artificial intelligence is our biggest existential threat[EB/OL](2014-10-24)[2017-04-01].

https://www.theguardian.com/technology/2014/oct/27/elon-musk-artificialintelligence-ai-biggest-existential-threat.

[15]Samantha Murphy.Bill Gates is another smart guy who is terrified of artificial intelligence[EB/OL](2015-01-28)[2017-04-01].

http://rmashable.com/2015/01/28/bill-gates-artificial-intelligence-reddit-ama/.

[16]Sam Shead.The biggest mystery in AI right now is the ethics board that Google set up after buying DeepMind[EB/OL](2016-03-26)[2017-04-01].http://uk.businessinsider.com/google-ai-ethics-board-remains-a-mystery-2016-3.

[17]Martin Bryant.Artificial Intelligence could kill us all,Meet the man who takes that risk seriously[EB/OL](2014-03-08)[2017-04-01].

http://thenextweb.com/insider/2014/03/08/ai-could-kill-all-meet-man-takes-risk-seriously/.

[18]Timothy B.Lee.Will artificial intelligence destroy humanity? Here are 5 reasons not to worry[EB/OL](2015-07-29)[2017-04-01].

http://www.vox.com/2014/8/22/6043635/5-reasons-we-shouldnt-worry-about-super-intelligent-computers-taking.

[19]Monica Nickelsburg.AI2 CEO Oren Etzioni envisions an artificial intelligence ‘utopia'[EB/OL](2016-03-30)[2017-04-01].

http://www.geekwire.com/2016/ai2-ceo-oren-etzioni-envisions-artificial-intelligence-utopia/.

[20]Ilkka Tuomi.Kurzweil,Moore,and Accelerating Change [EB/OL].(2003-08-27)[2017-04-01].http://www.meaningprocessing.com/personalPages/tuomi/articles/Kurzweil.pdf.

[21]Dan Wellers.7 Surprising Innovations For The Future Of Computing[EB/OL](2016-09-12)[2017-04-01].

http://ww.forbes.com/sites/sap/2016/09/12/7-surprising-innovations-for-the-future-of-computing/#7b763b78d402.

[22]Han Xu.Will AI Surpass Human Intelligence? Interview with Prof.Jürgen Schmidhuber on Deep Learning[EB/OL](2016-03-08)[2017-04-01].

https://www.infoq.com/articles/interviewschmidhuber-deep-learning.

[23]George P.Dvorsky.Humans With Amplified Intelligence Could Be More Powerful Than AI[EB/OL](2013-05-22)[2017-04-01].

http://io9.gizmodo.com/humans-with-amplified-intelligence-could-be-more-powerf-509309984.

[24]米格尔·尼科莱利斯.脑机穿越:脑机接口改变人类未来[M].黄珏苹,郑悠然,译.杭州:浙江人民出版社.2015:278.

[25]Nick Bostrom.Existential Risks:Analyzing Human Extinction Scenarios and Related Hazards[J].Journal of Evolution and Technology.2002,9(1):7.

[26]Anthony M.Barrett,Seth D.Baum.A Model of Pathways to Artificial Superintelligence Catastrophe for Risk and Decision Analysis[EB/OL](2017-03-03)[2017-04-01].https://arxiv.org/ftp/arxiv/papers/1607/1607.07730.pdf.

(原载《未来与发展》2017年第8期)